关键词:文化遗产;互联网;图片;数字重建

1 研究目标

对文化遗产进行三维数字化已经成为文化遗产保护的重要手段,这需要获取文化遗产的各种物理及几何信息,如尺寸、纹理、材质等。然而,由于自然及人为的破坏,一些文化遗产还未进行精细的数字存档就已经消亡。如何对已损毁的文化遗产进行有效的三维重建,是文化保护工作中面临的重大挑战。

随着大数据时代的到来,互联网上产生海量的数据。大数据为遗产保护工作带来了全新的视角和方法,本文提出使用互联网上随意拍摄的、无组织的照片,实现文化遗产,特别是已经损毁的文化遗产的三维重建和可视化。突破传统三维重建需要实地采集数据的思路,实现跨越时间和空间的文化遗产三维重建和展示宣传。

2 引言

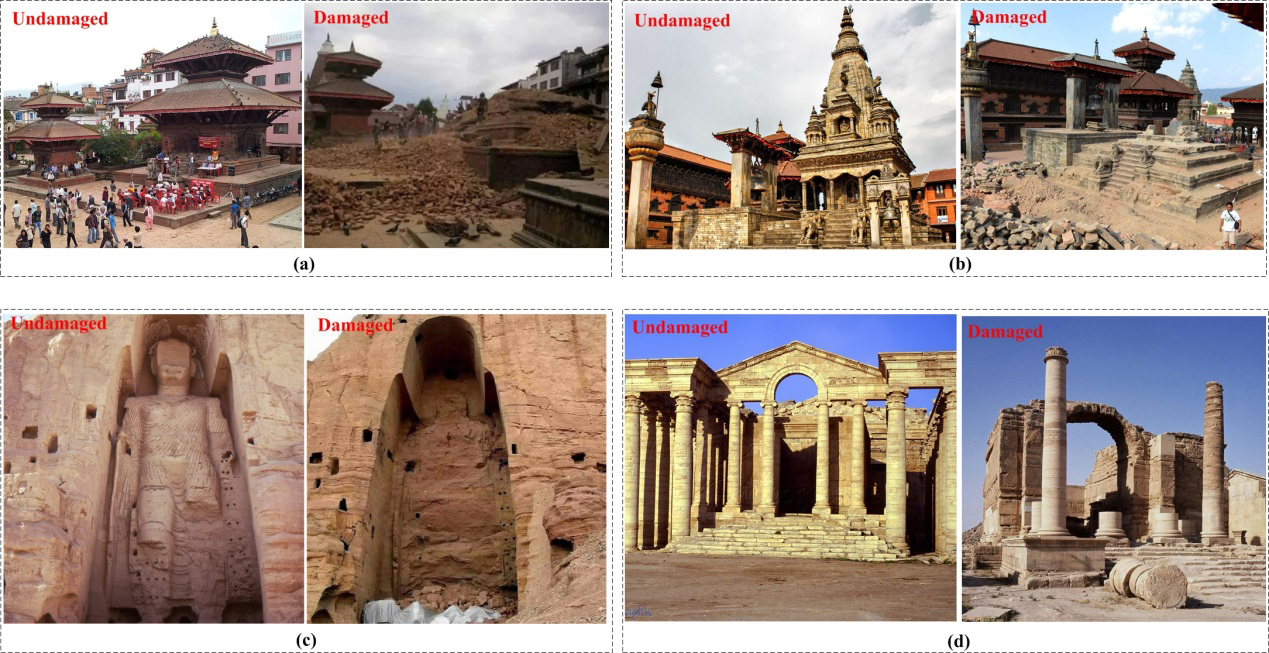

文化遗产是人类文明的产物,是人类共同的财富,反映了不同时期人类文明的高度和成就[1]。然而,很多文化遗产,正遭受或者已经遭受各种自然灾害如地震、洪水、火山爆发、海啸等,以及人为破坏,如战争与武装冲突、环境污染、城镇化等带来的毁灭性破坏[1, 2]。2015年4月25日尼泊尔地震中,损毁的重点古建筑共计14座,其中12座为世界文化遗产,大部分受损情况为完全坍塌如图1a,b。著名的世界文化遗产巴米扬大佛图1c,在2001年3月12日遭到塔利班政权的残酷轰炸,已面目全非。同样遭到人为破坏的还有哈特拉古城图1d,在2015年3月7日,哈特拉古城遗址遭到了“伊斯兰国”(IS)的毁灭性破坏。除了新闻报道的世界文化遗产,还有更多未列入世界文化遗产名录的其他文化遗产,正遭受严重破坏或者已经消亡。

图1 已损毁的世界文化遗产对比图。a,b,c,d分别为Char Narayan,

Vastala Durga Temple, Bamiyan Buddhas, Hatra损毁前后的对比图

在大数据时代背景下,互联网成为人们分享数据和获取数据的重要途径。每天有大量的游客前往世界各地的各个景点,大量拍摄的照片由此产生并传送到互联网上,其中有大量的照片拍摄于在文化遗产被损毁之前。例如,在谷歌浏览器中输入“哈特拉古城”,可以得到981,000 条搜索结果,其中包含了大量的图片,这些图片从不同位置、不同角度、不同时间拍摄。互联网上海量的图片为文化遗产的保护提供了新的机会和应用。

利用图片进行三维建模已经做了一些研究[8, 9] ,然而对于已损毁的文化遗产进行三维重建和可视化仍然是巨大的挑战。我们提出,充分利用互联网上所有资源,特别是文化遗产损毁前游客拍摄并上传的互联网照片,对已损毁的文化遗产进行数字重建。

3 方法

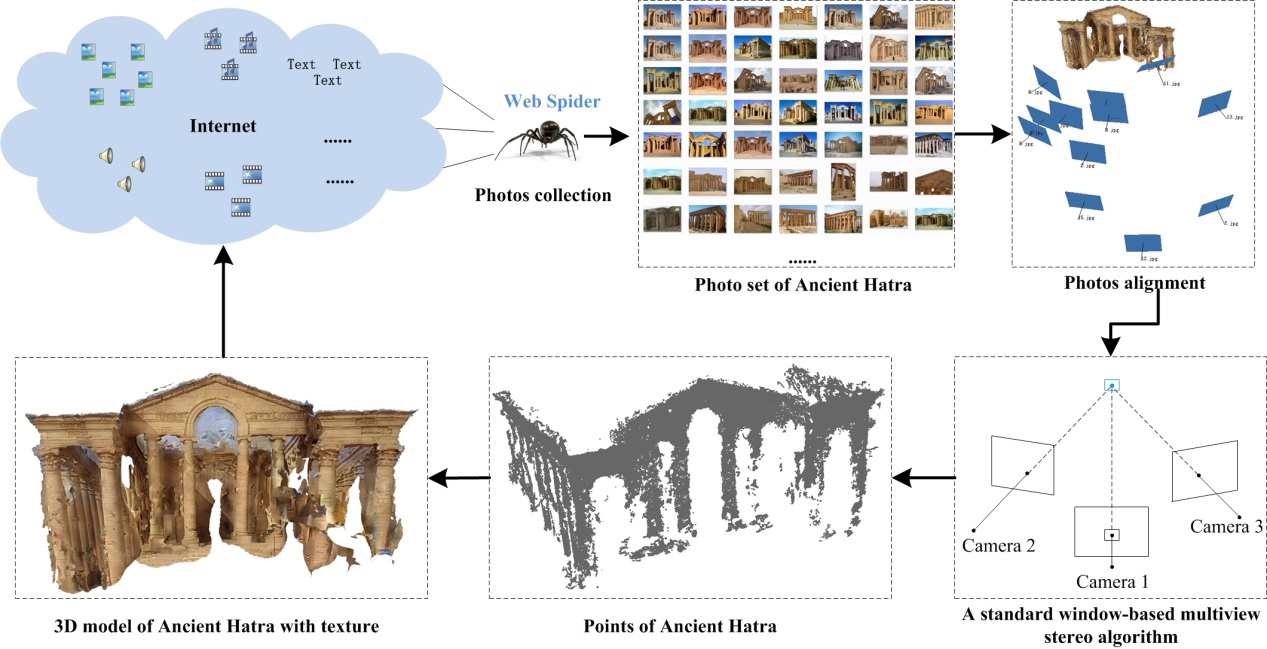

图2为本文研究方法的流程图,从互联网上搜集文化遗产损毁前拍摄的照片,通过摄影测量技术实现照片的定姿定态、点云的获取及三维重建,最后将得到的文化遗产的三维模型分享到互联网。

图2 技术流程图

3.1 互联网照片获取

使用文化遗产的关键字(例如文化遗产的名字),在互联网页面中选择满足要求的网页,例如Flickr,Google等,然后根据检索得到的网址,进行照片资源的分析,通过网页下载器,下载对应网页中的照片并保存到数据库,完成相应照片的自动爬取。

来自互联网的照片资源,由于拍摄人员、拍摄设备、分辨率、表达主题、角度、光照、天气等均不同,对于后续的三维重建提出了极高的技术要求。我们根据照片分辨率、光照条件、对比度等,人工地进行照片筛选,形成用于三维重建的高质量照片集。

3.2 基于照片建模

3.2.1特征提取及匹配

我们提出了一种鲁棒的仿射不变特征提取技术,能有效地提取高质量的局部不变特征。综合利用当前最优的特征提取算子MSER[10]和最优的特征描述算子SIFT[11],并提出了一种提出基于信息量和空间分布均衡性双重约束的多层次特征筛选方法[12]。特征区域被检测出后、进行特征描述前,以信息量和空间分布均衡性为衡量标准, 对提取出的特征进行评估,过滤掉信息量不佳、空间分布均衡性差的特征,只保留高质量特征,以提高特征的重复率以及后续的立体影像匹配的成功率,进而有利于后续的立体匹配。

获得特征之后,对每一对照片使用approximate nearest neighbors (ANN) kd-tree对特征点进行匹配。通过特征点的匹配得到匹配对之后,通过设定阈值对匹配对进行筛选,去除较差的匹配对。进一步使用RANSAC算法[13]对匹配对进行更精细的筛选,以提高匹配质量。

3.2.2 照片配准

完成特征匹配之后,选择匹配质量最高的一个像对,通过使用Nistér的five point algorithm获得初始匹配对的相机参数[14],进行立体交会生成稀疏点云。以此稀疏点云为参考,然后加入新的照片,对初始匹配对的相机参数进行优化,在此过程中使用直接线性转换 (DLT) [15]技术对新相机的内方位元素和外方位元素进行估计。重复步骤,直至所有的照片完成定位定姿态并恢复相机参数。

3.2.3 恢复点云及三维重建

确定照片的位置及相机的参数后,使用patch-based multi-view stereo(PMVS)[16]方法可以获取稠密的点云,主要步骤包括初始匹配,区域生长和filtering with visibility constraints。对目标物体的所有照片使用PMVS恢复得到有纹理信息的三维点云数据。为了获取更好的可视化效果,对三维点云构建3D mesh with high resolution images。通过互联网资源的查找筛选,可以得到文化遗产的尺寸信息,只需要一个及以上的尺寸信息,就可以控制重建的三维模型的大小。

4 结果与讨论

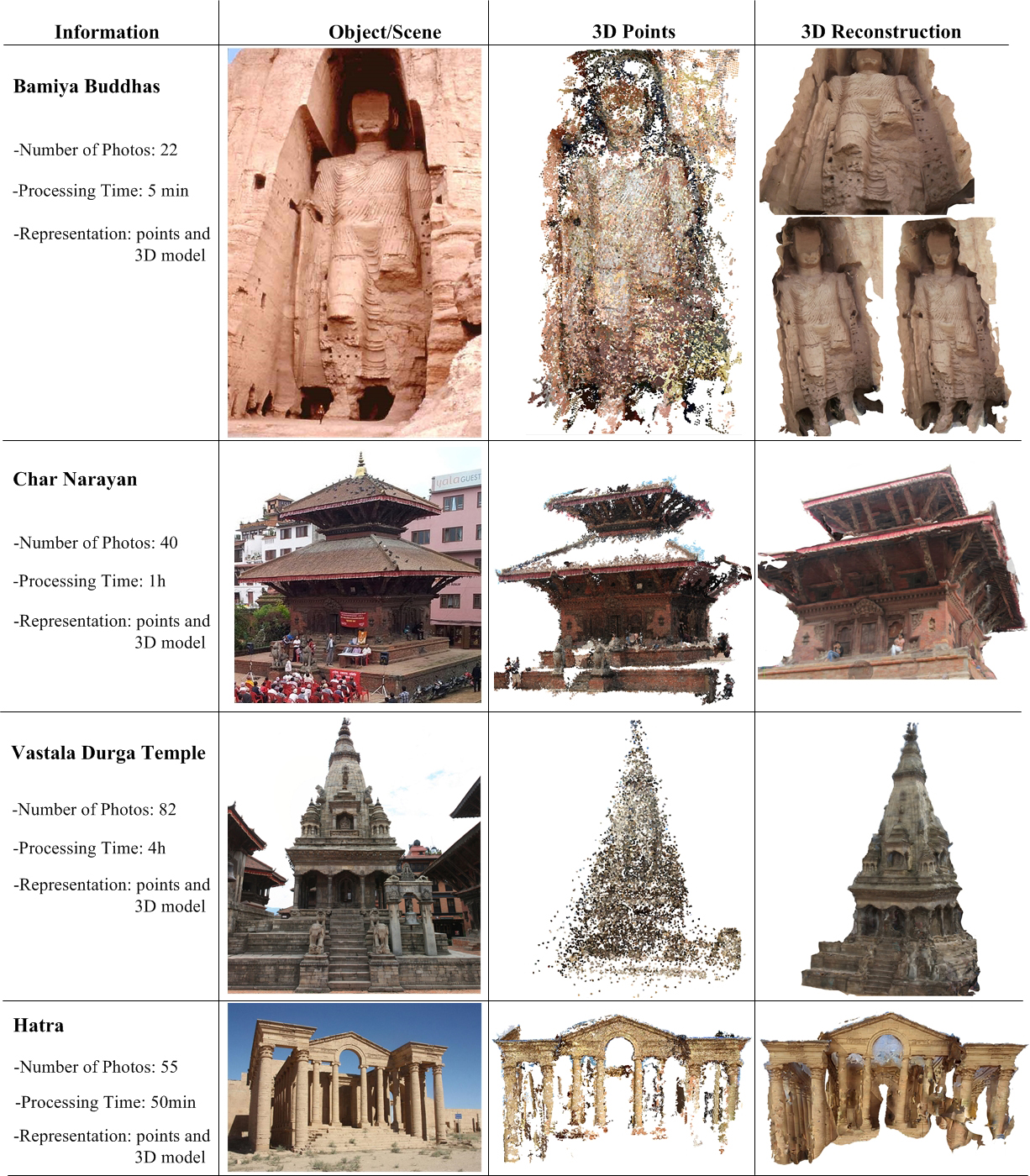

利用本文提出的方法和技术,对已损毁的世界文化遗产Bamiya Buddhas, Char Narayan, Vastala Durga Temple进行数字化重建,结果如图3所示。图中列出了每个目标数字化重建所用的照片数量以及处理时间。Bamiya Buddhas是180。分布的物体,只需要少量照片即可以完成数字化重建且耗时很短。而对于360。分布的物体,如Char Narayan和Vastala Durga Temple,要完成数字化重建需要较多的照片,且处理时间较长。从重建的效果来看,基于互联网照片能够有效地重建出世界文化遗产受损前的真实面貌。通过互联网照片不仅能恢复出真实场景的每一个细节,而且每个细节的纹理信息也能得到真实的反映。

图3 已损毁的文化遗产数字重建

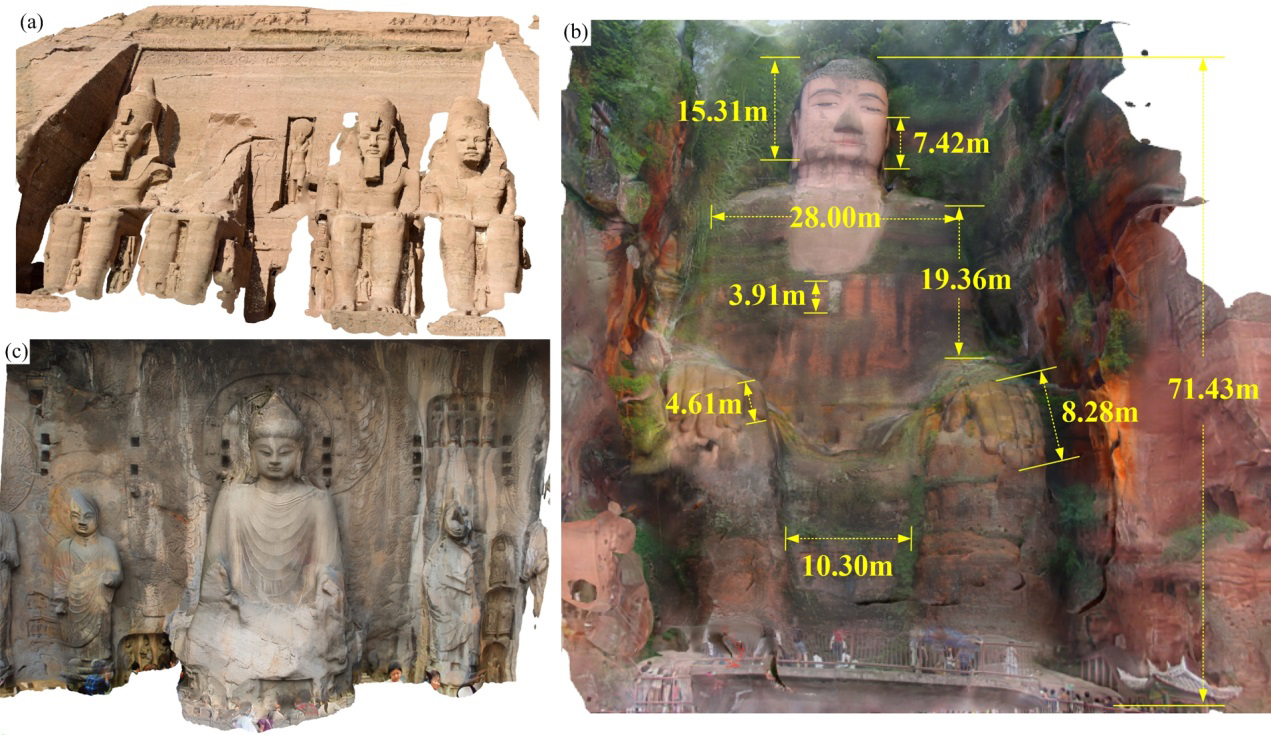

我们利用同样的技术,对现存文化遗产,如努比亚遗址、中国洛阳龙门石窟、乐山大佛(图4),做了同样的数字三维建模工作。我们能够恢复多少文化遗产的细节,取决于我们究竟能够从互联网上得到多少符合标准的照片。由于照片丰富,图4中展示的文化遗产可以得到更好的视觉效果和更精确的几何尺寸,甚至可以在重建的模型上进行量测。三维精细的数字文化遗产模型,可为三维打印技术在文化遗产保护中应用,提供重要数据源。

图4 其他文化遗产数字重建结果及量测图。a, b, c分别为SimbeltoPhilae,

Leshan Grand Buddha,Vairocana Buddha数字重建的三维模型

5 结论

本文提出使用互联网资源对已损毁的文化遗产进行数字重建的方法,能有效地解决已损毁的文化遗产因缺少足够的实地测量数据实现数字化重建的巨大挑战,并为文化遗产的修缮和物理重建工作提供了支撑。此外,本文提出的方法不需要使用专业昂贵的测量仪器,成本较低,重建的结果也让人满意,这使得其适用性十分广泛。

但本文的算法主要基于图像处理和摄影测量技术,对图片的质量和数量要求很高,要获取更高精度的重建效果,需要大量且质量好的照片。相应的文化遗产保护部门可以呼吁公众,在旅游中多拍摄文化遗产的照片且分享到互联网上,为文化遗产的保护贡献自己的一份力量。

参考文献

[1] A. Cazenave, Anthropogenic global warming threatens world cultural heritage, Environ. Res. Lett., 9 (2014) 051001.

[2] S. di Lernia, Save Libyan archaeology, Nature, 517 (2015) 547-549.

[3] A. Kioussi, M. Karoglou, K. Labropoulos, A. Bakolas, A. Moropoulou, Integrated documentation protocols enabling decision making in cultural heritage protection, J. Cult. Herit., 14 (2013) e141-e146.

[4] W. Yan, A. Behera, P. Rajan, Recording and documenting the chromatic information of architectural heritage, J. Cult. Herit., 11 (2010) 438-451.

[5] A.N.e. Andr?©s, F.B. Pozuelo, J.n.R. Marim?3n, A.s. de Mesa Gisbert, Generation of virtual models of cultural heritage, J. Cult. Herit., 13 (2012) 103-106.

[6] L. Cheng, Y. Wang, Y. Chen, M. Li, Using LiDAR for digital documentation of ancient city walls, J. Cult. Herit., (2015).

[7] R. Zlot, M. Bosse, K. Greenop, Z. Jarzab, E. Juckes, J. Roberts, Efficiently capturing large, complex cultural heritage sites with a handheld mobile 3D laser mapping system, J. Cult. Herit., 15 (2014) 670-678.

[8] B. Alsadik, M. Gerke, G. Vosselman, Automated camera network design for 3D modeling of cultural heritage objects, J. Cult. Herit., 14 (2013) 515-526.

[9] N. Snavely, S.M. Seitz, R. Szeliski, Modeling the world from internet photo collections, Int. J. Comput. Vision, 80 (2008) 189-210.

[10] J. Matas, O. Chum, M. Urban, T.s. Pajdla, Robust wide-baseline stereo from maximally stable extremal regions, Int. J. Comput. Vision, 22 (2004) 761-767.

[11] P.C. Ng, S. Henikoff, SIFT: Predicting amino acid changes that affect protein function, Nucleic acids res., 31 (2003) 3812-3814.

[12] L. Cheng, J. Gong, X. Yang, C. Fan, P. Han, Robust affine invariant feature extraction for image matching, IEEE Geosci. Remote Sens. Lett., , 5 (2008) 246-250.

[13] Z. Yaniv, Random sample consensus (RANSAC) algorithm, a generic implementation, Imaging, (2010).

[14] D. Nist?©r, An efficient solution to the five-point relative pose problem, Pattern Analysis and Machine Intelligence, IEEE Trans. Pattern Anal. Mach. Intell., 26 (2004) 756-770.

[15] H.M. Fritz, D.A. Phillips, A. Okayasu, T. Shimozono, H. Liu, F. Mohammed, V. Skanavis, C.E. Synolakis, T. Takahashi, The 2011 Japan tsunami current velocity measurements from survivor videos at Kesennuma Bay using LiDAR, Geophys. Res. Lett., 39 (2012).

[16] Y. Furukawa, J. Ponce, Accurate camera calibration from multi-view stereo and bundle adjustment, Int. J. Comput. Vision, 84 (2009) 257-268.